Testaa YRITYSTÄSI Minuutissa

Luo tilisi ja käynnistä AI-chatbottisi minuuteissa. Täysin mukautettavissa, koodausta ei tarvita - aloita asiakkaidesi sitouttaminen välittömästi!

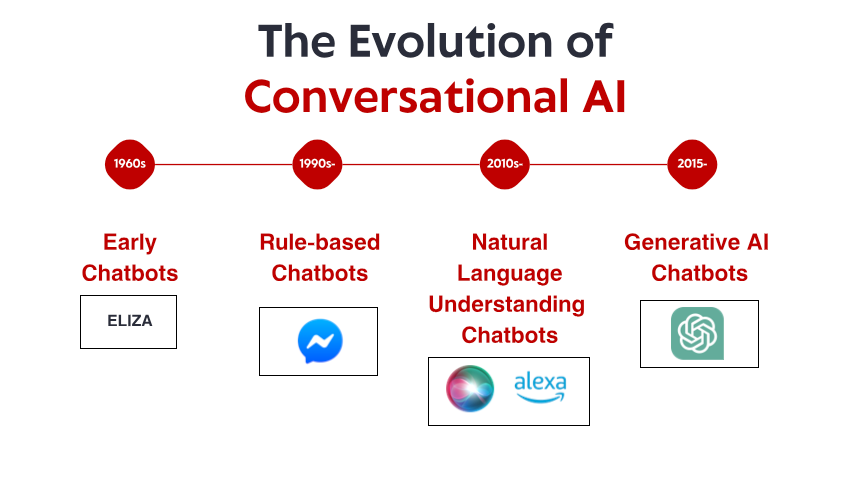

Vaatimaton alku: Varhaiset sääntöpohjaiset järjestelmät

ELIZAn merkittävä ei ollut sen tekninen hienostuneisuus – nykystandardien mukaan ohjelma oli uskomattoman yksinkertainen. Pikemminkin sen syvällinen vaikutus käyttäjiin. Vaikka he tiesivät puhuvansa tietokoneohjelmalle ilman todellista ymmärrystä, monet ihmiset muodostivat emotionaalisen yhteyden ELIZAan ja jakoivat syvästi henkilökohtaisia ajatuksia ja tunteita. Tämä ilmiö, jota Weizenbaum itse piti häiritsevänä, paljasti jotain perustavanlaatuista ihmisen psykologiasta ja halukkuudestamme antropomorfisoida jopa yksinkertaisimmat keskustelukäyttöliittymät.

1970- ja 1980-luvuilla sääntöpohjaiset chatbotit seurasivat ELIZAn mallia vähittäisin parannuksin. Ohjelmat, kuten PARRY (joka simuloi vainoharhaista skitsofreenikkoa) ja RACTER (joka "kirjoitti" kirjan nimeltä "Poliisin parta on puoliksi rakennettu"), pysyivät tiukasti sääntöpohjaisen paradigman sisällä – käyttäen ennalta määriteltyjä malleja, avainsanojen yhteensovittamista ja mallipohjaisia vastauksia.

Näillä varhaisilla järjestelmillä oli vakavia rajoituksia. Ne eivät kyenneet itse asiassa ymmärtämään kieltä, oppimaan vuorovaikutuksesta tai sopeutumaan odottamattomiin syötteisiin. Niiden tietämys rajoittui niihin sääntöihin, jotka heidän ohjelmoijansa olivat nimenomaisesti määritelleet. Kun käyttäjät väistämättä eksyivät näiden rajojen ulkopuolelle, älykkyyden illuusio särkyi nopeasti paljastaen alla olevan mekaanisen luonteen. Näistä rajoituksista huolimatta nämä uraauurtavat järjestelmät loivat perustan, jolle kaikki tulevaisuuden keskustelullinen tekoäly rakennettaisiin.

Tiedon vallankumous: Asiantuntijajärjestelmät ja strukturoitu tieto

Asiantuntijajärjestelmät, kuten MYCIN (joka diagnosoi bakteeri-infektioita) ja DENDRAL (joka tunnisti kemiallisia yhdisteitä), järjestivät tietoa jäsenneltyihin tietokantoihin ja käyttivät päättelymoottoreita johtopäätösten tekemiseen. Keskustelurajapintoihin sovellettuna tämä lähestymistapa mahdollisti chatbottien siirtymisen yksinkertaisesta kuvioiden yhteensovittamisesta kohti päättelyä muistuttavaa tekniikkaa – ainakin kapeilla aloilla.

Yritykset alkoivat ottaa käyttöön käytännön sovelluksia, kuten automatisoituja asiakaspalvelujärjestelmiä, jotka käyttävät tätä teknologiaa. Nämä järjestelmät käyttivät tyypillisesti päätöspuita ja valikkopohjaisia vuorovaikutuksia vapaamuotoisen keskustelun sijaan, mutta ne edustivat varhaisia yrityksiä automatisoida vuorovaikutuksia, jotka aiemmin vaativat ihmisen puuttumista asiaan.

Rajoitukset pysyivät merkittävinä. Nämä järjestelmät olivat hauraita, eivätkä kyenneet käsittelemään odottamattomia syötteitä sujuvasti. Ne vaativat tietoinsinööreiltä valtavia ponnisteluja tiedon ja sääntöjen manuaaliseen koodaamiseen. Ja kenties tärkeintä, he eivät vieläkään kyenneet todella ymmärtämään luonnollista kieltä sen täydessä monimutkaisuudessa ja monitulkintaisuudessa.

Siitä huolimatta tämä aikakausi loi tärkeitä käsitteitä, joista myöhemmin tuli ratkaisevia nykyaikaiselle keskustelupohjaiselle tekoälylle: strukturoitu tiedon esittäminen, looginen päättely ja toimialojen erikoistuminen. Näyttämö oli luomassa pohjaa paradigman muutokselle, vaikka teknologia ei ollut vielä aivan valmiina.

Luonnollisen kielen ymmärtäminen: Laskennallisen kielitieteen läpimurto

Tämän muutoksen mahdollistivat useat tekijät: lisääntynyt laskentateho, paremmat algoritmit ja ennen kaikkea suurten tekstiaineistojen saatavuus, joita voitiin analysoida kielellisten kaavojen tunnistamiseksi. Järjestelmiin alettiin sisällyttää tekniikoita, kuten:

Sanaluokkien merkitseminen: Sen tunnistaminen, toimivatko sanat substantiiveina, verbeinä, adjektiiveina jne.

Nimettyjen entiteettien tunnistus: Oikeisnimien (henkilöt, organisaatiot, sijainnit) havaitseminen ja luokittelu.

Sentimenttianalyysi: Tekstin emotionaalisen sävyn määrittäminen.

Jäsentäminen: Lauserakenteen analysointi sanojen välisten kieliopillisten suhteiden tunnistamiseksi.

Yksi merkittävä läpimurto tuli IBM:n Watsonilla, joka voitti kuuluisasti ihmismestarit Jeopardy!-tietokilpailussa. vuonna 2011. Vaikka Watson ei ollutkaan varsinaisesti keskustelujärjestelmä, se osoitti ennennäkemättömiä kykyjä ymmärtää luonnollisen kielen kysymyksiä, hakea laajoista tietovarastoista ja muotoilla vastauksia – ominaisuuksia, jotka osoittautuisivat välttämättömiksi seuraavan sukupolven chatboteille.

Kaupalliset sovellukset seurasivat pian perässä. Applen Siri lanseerattiin vuonna 2011 ja toi keskustelukäyttöliittymät valtavirran kuluttajien saataville. Vaikka Siri oli nykystandardien rajoittama, se edusti merkittävää edistysaskelta tekoälyavustajien saatavuuden parantamisessa jokapäiväisille käyttäjille. Microsoftin Cortana, Googlen Assistant ja Amazonin Alexa seurasivat perässä, ja kukin vei eteenpäin kuluttajille suunnatun keskustelutekoälyn huippua.

Näistä edistysaskeleista huolimatta tämän aikakauden järjestelmät kamppailivat edelleen kontekstin, maalaisjärjen ja todella luonnollisilta kuulostavien vastausten luomisen kanssa. Ne olivat kehittyneempiä kuin sääntöihin perustuvat esi-isänsä, mutta niiden kielen ja maailman ymmärtäminen oli pohjimmiltaan rajallista.

Koneoppiminen ja datalähtöinen lähestymistapa

Tänä aikakautena aikomusten luokittelu ja entiteettien erottaminen nousivat keskusteluarkkitehtuurin ydinosiksi. Kun käyttäjä teki pyynnön, järjestelmä:

Luokitteli yleisen aikomuksen (esim. lennon varaaminen, sään tarkistaminen, musiikin soittaminen)

Poimi asiaankuuluvat entiteettit (esim. sijainnit, päivämäärät, kappaleiden nimet)

Yhdisti nämä tiettyihin toimintoihin tai vastauksiin

Facebookin (nykyään Metan) Messenger-alustan lanseeraus vuonna 2016 mahdollisti kehittäjille chatbottien luomisen, jotka tavoittivat miljoonia käyttäjiä, mikä herätti kaupallisen kiinnostuksen aallon. Monet yritykset kiirehtivät ottamaan chatbotteja käyttöön, vaikka tulokset olivat vaihtelevia. Varhaiset kaupalliset käyttöönotot turhauttivat usein käyttäjiä rajoitetulla ymmärryksellä ja jäykillä keskustelukuluilla.

Myös keskustelujärjestelmien tekninen arkkitehtuuri kehittyi tänä aikana. Tyypillinen lähestymistapa sisälsi erikoistuneiden komponenttien prosessin:

Automaattinen puheentunnistus (ääniliittymille)

Luonnollisen kielen ymmärtäminen

Dialogien hallinta

Luonnollisen kielen generointi

Tekstistä puheeksi (ääniliittymille)

Jokainen komponentti voitiin optimoida erikseen, mikä mahdollisti asteittaiset parannukset. Nämä prosessiarkkitehtuurit kärsivät kuitenkin joskus virheiden etenemisestä – virheet alkuvaiheessa levisivät koko järjestelmään.

Vaikka koneoppiminen paransi merkittävästi ominaisuuksia, järjestelmillä oli edelleen vaikeuksia ylläpitää kontekstia pitkien keskustelujen aikana, ymmärtää implisiittistä tietoa ja luoda todella monimuotoisia ja luonnollisia vastauksia. Seuraava läpimurto vaatisi radikaalimpaa lähestymistapaa.

Transformer-vallankumous: Neuraalisten kielten mallit

Tämä innovaatio mahdollisti yhä tehokkaampien kielimallien kehittämisen. Vuonna 2018 Google esitteli BERT:n (Bidirectional Encoder Representations from Transformers), joka paransi dramaattisesti suorituskykyä erilaisissa kielen ymmärtämistehtävissä. Vuonna 2019 OpenAI julkaisi GPT-2:n, joka osoitti ennennäkemättömiä kykyjä luoda johdonmukaista ja kontekstissaan relevanttia tekstiä.

Dramaattisin harppaus tapahtui vuonna 2020 GPT-3:n kanssa, joka skaalautui 175 miljardiin parametriin (verrattuna GPT-2:n 1,5 miljardiin). Tämä massiivinen skaalauskasvu yhdistettynä arkkitehtuurisiin hienosäätöihin tuotti laadullisesti erilaisia ominaisuuksia. GPT-3 pystyi tuottamaan huomattavan ihmismäistä tekstiä, ymmärtämään kontekstia tuhansien sanojen läpi ja jopa suorittamaan tehtäviä, joihin sitä ei ollut nimenomaisesti koulutettu.

Keskustelupohjaisen tekoälyn osalta nämä edistysaskeleet käännettiin chatbottien kaltaisiksi, jotka kykenivät:

Ylläpitämään johdonmukaisia keskusteluja useiden vuorojen ajan

Ymmärtämään vivahteikkaita kyselyitä ilman erillistä koulutusta

Tuottamaan monipuolisia, kontekstiin sopivia vastauksia

Mukauttamaan sävyään ja tyyliään käyttäjän mukaan

Käsittelemään epäselvyyksiä ja selventämään tarvittaessa

ChatGPT:n julkaisu vuoden 2022 lopulla toi nämä ominaisuudet valtavirtaan ja houkutteli yli miljoona käyttäjää muutamassa päivässä julkaisunsa jälkeen. Yhtäkkiä suurella yleisöllä oli pääsy keskustelevaan tekoälyyn, joka vaikutti laadullisesti erilaiselta kuin mikään aiempi – joustavammalta, asiantuntevammalta ja luonnollisemmalta vuorovaikutuksessaan.

Kaupalliset käyttöönotot seurasivat nopeasti, ja yritykset sisällyttivät laajoja kielimalleja asiakaspalvelualustoihinsa, sisällöntuotantotyökaluihinsa ja tuottavuussovelluksiinsa. Nopea käyttöönotto heijasti sekä teknologista harppausta että näiden mallien tarjoamaa intuitiivista käyttöliittymää – keskustelu on loppujen lopuksi luonnollisin tapa ihmisille kommunikoida.

Testaa YRITYSTÄSI Minuutissa

Luo tilisi ja käynnistä AI-chatbottisi minuuteissa. Täysin mukautettavissa, koodausta ei tarvita - aloita asiakkaidesi sitouttaminen välittömästi!

Multimodaaliset ominaisuudet: Pelkkien tekstikeskustelujen tuolla puolen

Näkökielimallit, kuten DALL-E, Midjourney ja Stable Diffusion, osoittivat kyvyn luoda kuvia tekstikuvauksista, kun taas mallit, kuten GPT-4, joilla oli näköominaisuudet, pystyivät analysoimaan kuvia ja keskustelemaan niistä älykkäästi. Tämä avasi uusia mahdollisuuksia keskustelukäyttöliittymille:

Asiakaspalvelubotit, jotka pystyvät analysoimaan vaurioituneiden tuotteiden valokuvia

Ostoavustajat, jotka pystyvät tunnistamaan tuotteita kuvista ja löytämään samankaltaisia tuotteita

Koulutustyökalut, jotka pystyvät selittämään kaavioita ja visuaalisia käsitteitä

Esteettömyysominaisuudet, jotka pystyvät kuvailemaan kuvia näkövammaisille käyttäjille

Myös ääniominaisuudet ovat kehittyneet dramaattisesti. Varhaiset puhekäyttöliittymät, kuten IVR (Interactive Voice Response) -järjestelmät, olivat tunnetusti turhauttavia, ja ne rajoittuivat jäykkiin komentoihin ja valikkorakenteisiin. Nykyaikaiset ääniavustajat ymmärtävät luonnollisia puhekuvioita, ottavat huomioon erilaisia aksentteja ja puhevaikeuksia ja vastaavat yhä luonnollisemmilta kuulostavilla syntetisoiduilla äänillä.

Näiden ominaisuuksien yhdistelmä luo aidosti multimodaalisen keskustelevan tekoälyn, joka pystyy saumattomasti vaihtamaan eri viestintätilojen välillä kontekstin ja käyttäjän tarpeiden mukaan. Käyttäjä voi aloittaa tekstiviestikysymyksellä tulostimen korjaamisesta, lähettää kuvan virheilmoituksesta, vastaanottaa kaavion, jossa korostetaan asiaankuuluvia painikkeita, ja sitten vaihtaa ääniohjeisiin, kun hänen kätensä ovat kiireisiä korjauksen parissa.

Tämä multimodaalinen lähestymistapa ei edusta vain teknistä edistystä, vaan perustavanlaatuista muutosta kohti luonnollisempaa ihmisen ja tietokoneen vuorovaikutusta – käyttäjien kohtaaminen missä tahansa viestintätilassa, joka sopii parhaiten heidän nykyiseen kontekstiinsa ja tarpeisiinsa.

Haku- ja lisäarvogenerointi: tekoälyn perustaminen faktoihin

Haku-laajennettu generointi (RAG) nousi esiin ratkaisuna näihin haasteisiin. Sen sijaan, että RAG-järjestelmät luottaisivat pelkästään harjoituksen aikana opittuihin parametreihin, ne yhdistävät kielimallien generatiiviset kyvyt hakumekanismeihin, jotka voivat käyttää ulkoisia tietolähteitä. Tyypillinen RAG-arkkitehtuuri toimii näin:

Järjestelmä vastaanottaa käyttäjän kyselyn

Se etsii kyselyyn liittyviä tietoja asiaankuuluvista tietokannoista

Se syöttää sekä kyselyn että noudetut tiedot kielimallille

Malli luo vastauksen, joka perustuu noudettuihin faktoihin

Tämä lähestymistapa tarjoaa useita etuja:

Tarkempia, faktoihin perustuvia vastauksia perustamalla generointi varmennettuun tietoon

Mahdollisuus käyttää ajantasaista tietoa mallin koulutusrajan yli

Erikoistunutta tietoa toimialakohtaisista lähteistä, kuten yrityksen dokumentaatiosta

Läpinäkyvyys ja attribuutio mainitsemalla tietolähteet

Yrityksille, jotka ottavat käyttöön keskustelevaa tekoälyä, RAG on osoittautunut erityisen arvokkaaksi asiakaspalvelusovelluksissa. Esimerkiksi pankki-chatbotti voi käyttää uusimpia käytäntöasiakirjoja, tilitietoja ja tapahtumatietoja tarjotakseen tarkkoja, yksilöllisiä vastauksia, jotka olisivat mahdottomia erillisellä kielimallilla.

RAG-järjestelmien kehitys jatkuu parantuen hakutarkkuudessa, kehittyneemmissä menetelmissä noudettujen tietojen integroimiseksi luotuun tekstiin ja parempien mekanismien myötä eri tietolähteiden luotettavuuden arvioimiseksi.

Ihmisen ja tekoälyn yhteistyömalli: oikean tasapainon löytäminen

Nykyään menestyneimmät toteutukset noudattavat yhteistyömallia, jossa:

Tekoäly käsittelee rutiininomaisia, toistuvia kyselyitä, jotka eivät vaadi ihmisen harkintaa

Ihmiset keskittyvät monimutkaisiin tapauksiin, jotka vaativat empatiaa, eettistä päättelyä tai luovaa ongelmanratkaisua

Järjestelmä tuntee rajoituksensa ja siirtyy sujuvasti ihmisagenteille tarvittaessa

Siirtymä tekoälyn ja ihmisen tuen välillä on käyttäjälle saumaton

Ihmisen agenteilla on täysi konteksti keskusteluhistoriasta tekoälyn kanssa

Tekoäly oppii jatkuvasti ihmisen toimista ja laajentaa kykyjään vähitellen

Tämä lähestymistapa tunnistaa, että keskustelevan tekoälyn ei pitäisi pyrkiä korvaamaan ihmisen vuorovaikutusta kokonaan, vaan pikemminkin täydentämään sitä – käsittelemällä suuren volyymin, suoraviivaisia kyselyitä, jotka vievät ihmisagenttien aikaa, samalla varmistaen, että monimutkaiset kysymykset tavoittavat oikean ihmisasiantuntemuksen.

Tämän mallin toteutus vaihtelee toimialoittain. Terveydenhuollossa tekoälychatbotit saattavat hoitaa ajanvarauksen ja oireiden perusseulonnan varmistaen samalla, että lääketieteelliset neuvot tulevat päteviltä ammattilaisilta. Lakipalveluissa tekoäly voi auttaa asiakirjojen valmistelussa ja tutkimuksessa, mutta jättää tulkinnan ja strategian asianajajille. Asiakaspalvelussa tekoäly voi ratkaista yleisiä ongelmia ja ohjata monimutkaisia ongelmia erikoistuneille edustajille.

Tekoälyn ominaisuuksien kehittyessä raja ihmisen osallistumista vaativien ja automatisoitavien asioiden välillä muuttuu, mutta perusperiaate pysyy samana: tehokkaan keskustelullisen tekoälyn tulisi parantaa ihmisen kykyjä sen sijaan, että se vain korvaisi ne.

Tulevaisuuden maisema: Minne keskusteleva tekoäly on menossa

Personointi skaalautuvasti: Tulevaisuuden järjestelmät räätälöivät vastauksiaan yhä enemmän paitsi välittömään kontekstiin, myös kunkin käyttäjän viestintätyyliin, mieltymyksiin, tietämykseen ja suhdehistoriaan. Tämä personointi tekee vuorovaikutuksesta luonnollisempaa ja merkityksellisempää, vaikka se herättääkin tärkeitä kysymyksiä yksityisyydestä ja datan käytöstä.

Tunneäly: Vaikka nykyiset järjestelmät pystyvät havaitsemaan perusmielipiteitä, tulevaisuuden keskustelupohjainen tekoäly kehittää kehittyneempää tunneälyä – se tunnistaa hienovaraisia tunnetiloja, reagoi asianmukaisesti ahdistukseen tai turhautumiseen ja mukauttaa sävyään ja lähestymistapaansa vastaavasti. Tämä ominaisuus on erityisen arvokas asiakaspalvelu-, terveydenhuolto- ja koulutussovelluksissa.

Ennakoiva apu: Sen sijaan, että seuraavan sukupolven keskustelupohjaiset järjestelmät odottaisivat nimenomaisia kyselyitä, ne ennakoivat tarpeita kontekstin, käyttäjähistorian ja ympäristösignaalien perusteella. Järjestelmä saattaa huomata, että olet varaamassa useita tapaamisia tuntemattomassa kaupungissa, ja tarjota ennakoivasti kuljetusvaihtoehtoja tai sääennusteita.

Saumaton multimodaalinen integrointi: Tulevaisuuden järjestelmät siirtyvät pelkän eri modaliteetin tukemisen lisäksi niiden saumattomaan integrointiin. Keskustelu voi kulkea luonnollisesti tekstin, äänen, kuvien ja interaktiivisten elementtien välillä, jolloin jokaiselle tiedolle valitaan oikea modaliteetti ilman käyttäjän nimenomaista valintaa.

Erikoisalojen asiantuntijat: Vaikka yleiskäyttöiset avustajat kehittyvät jatkuvasti, näemme myös erittäin erikoistuneen keskustelupohjaisen tekoälyn nousun, jolla on syvällistä asiantuntemusta tietyillä aloilla – oikeudelliset avustajat, jotka ymmärtävät oikeuskäytäntöä ja ennakkotapauksia, lääketieteelliset järjestelmät, joilla on kattava tietämys lääkkeiden yhteisvaikutuksista ja hoitoprotokollista, tai talousneuvojat, jotka tuntevat verosäännökset ja sijoitusstrategiat.

Aidosti jatkuva oppiminen: Tulevaisuuden järjestelmät siirtyvät säännöllisestä uudelleenkoulutuksesta jatkuvaan oppimiseen vuorovaikutuksista, muuttuen ajan myötä hyödyllisemmiksi ja henkilökohtaisemmiksi samalla, kun ne säilyttävät asianmukaiset yksityisyyden suojan.

Näistä jännittävistä mahdollisuuksista huolimatta haasteita on edelleen. Yksityisyyden suojaan liittyvät huolenaiheet, puolueellisuuden vähentäminen, asianmukainen läpinäkyvyys ja oikean tason ihmisen valvonnan varmistaminen ovat jatkuvia kysymyksiä, jotka muokkaavat sekä teknologiaa että sen sääntelyä. Onnistuneimmat toteutukset ovat niitä, jotka vastaavat näihin haasteisiin harkiten ja tarjoavat samalla aitoa arvoa käyttäjille.

On selvää, että keskustelupohjainen tekoäly on siirtynyt niche-teknologiasta valtavirran käyttöliittymäparadigmaksi, joka välittää yhä enemmän vuorovaikutustamme digitaalisten järjestelmien kanssa. Evoluutiopolku ELIZAn yksinkertaisesta hahmontunnistuksesta nykypäivän kehittyneisiin kielimalleihin on yksi merkittävimmistä edistysaskeleista ihmisen ja tietokoneen vuorovaikutuksessa – ja matka on kaikkea muuta kuin ohi.